|

Опрос

|

реклама

Быстрый переход

Google так и не решила проблемы с расовой инклюзивностью у генератора изображений Gemini

18.05.2024 [11:33],

Павел Котов

В феврале Google приостановила работу основанного на искусственном интеллекте генератора изображений Gemini, который допускал оскорбляющие общественность исторические неточности. К примеру, расовое разнообразие солдат по запросу «римский легион» — явный анахронизм — и стереотипно чёрные мужчины по запросу «зулусские воины». Кажется, ничего не изменилось до сих пор.

Источник изображения: blog.google Гендиректору Google Сундару Пичаи (Sundar Pichai) пришлось принести извинения за сбой в работе генератора изображений Gemini, а глава ответственного за проект профильного подразделения Google DeepMind Демис Хассабис (Demis Hassabis) пообещал, что ошибка будет исправлена в «кратчайшие сроки» — за несколько недель. Сейчас уже середина мая, а ошибка до сих пор не исправлена. На этой неделе Google провела ежегодную конференцию I/O, на которой рассказала о множестве новых функций Gemini: модель ИИ сможет использоваться для создания собственных чат-ботов, планировки маршрутов, она будет интегрирована в Google Calendar, Keep и YouTube Music. Но генерация изображений до сих пор отключена в приложении Gemini и веб-интерфейсе, подтвердил ресурсу TechCrunch представитель Google. Причин задержки он не пояснил. По одной из версий, при обучении ИИ используются наборы данных, в которых превалируют изображения белых людей, тогда как представители других рас и этнических групп составляют исключения, что формирует стереотипы. В попытке исправить этот перекос Google могла прибегнуть к кардинальной мере — жёсткому кодированию, при котором данные встраиваются непосредственно в исходный код. Исправить созданный таким образом алгоритм очень непросто. Президент OpenAI опубликовал изображение, созданное GPT-4o — оно очень впечатляет

18.05.2024 [11:20],

Павел Котов

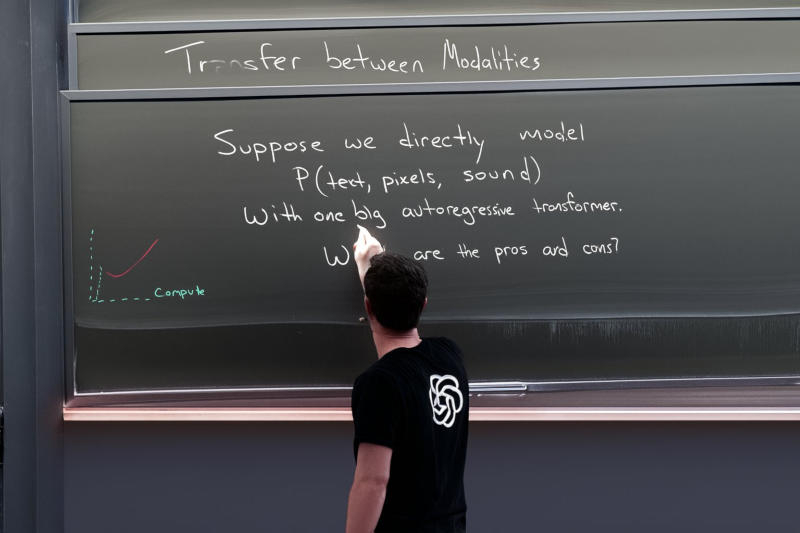

На этой неделе OpenAI представила модель искусственного интеллекта нового поколения GPT-4o. Буква «o» в её названии означает Omni, подразумевая, что она изначально поддерживает несколько форматов ввода — ранее мультимодальность предполагала преобразование всех нетекстовых форматов в текст. Президент и соучредитель OpenAI Грег Брокман (Greg Brockman) впервые опубликовал созданное GPT-4o изображение.

То самое сгенерированное GPT-4o изображение. Источник изображения: twitter.com/gdb Поддержка текста, изображений и звука в качестве входных данных означает, что модель также способна их генерировать. Приведённая выше картинка — не фотография, а творение GPT-4o. На ней изображён мужчина в футболке с логотипом OpenAI, который пишет на доске. Сверху находится частично стёртая надпись «Перенос между модальностями». Далее следует текст: «Положим, мы напрямую моделируем P (текст, пиксели, звук) посредством одного авторегрессионного трансформера. Каковы за и против?». Если присмотреться, можно разглядеть некоторые признаки того, что изображение было создано ИИ. Доска висит под неестественным углом, под ней непонятным образом находится ещё одна, рука мужчины имеет странную форму, а освещение неоднородно. Невероятной, вместе с тем, кажется способность ИИ генерировать длинные фрагменты связного текста — с этим с трудом справляется даже DALL-E 3. Генератор изображений GPT-4o широкой публике пока недоступен: пользователи ChatGPT с подключённой моделью нового поколения пока могут генерировать изображения лишь с DALL-E 3. Но президент OpenAI Грег Брокман уверяет, что компания прилагает значительные усилия, чтобы открыть к модели нового поколения полный доступ. Sony пригрозила 700 компаниям судом за несанкционированное использование музыки для обучения ИИ

17.05.2024 [19:54],

Сергей Сурабекянц

Sony Music Group разослала предупреждения более чем 700 технологическим компаниям и службам потоковой передачи музыки о недопустимости использования защищённого авторским правом аудиоконтента для обучения ИИ без явного разрешения. Компания признает «значительный потенциал» ИИ, но «несанкционированное использование контента в обучении, разработке или коммерциализации систем ИИ» лишает её и её артистов контроля и «соответствующей компенсации».

Источник изображения: Pixabay В части разосланных писем Sony Music прямо утверждает, что имеет «основания полагать», что получатели письма «возможно, уже совершили несанкционированное использование» принадлежащего компании музыкального контента. В портфолио Sony Music — множество известных артистов, среди них Harry Styles, Beyonce, Adele и Celine Dion. Компания стремится защитить свою интеллектуальную собственность, включая аудио- и аудиовизуальные записи, обложки, метаданные и тексты песен. Компания не раскрыла список адресатов, получивших «письма счастья». «Мы поддерживаем артистов и авторов песен, которые берут на себя инициативу по использованию новых технологий в поддержку своего искусства, — говорится в заявлении Sony Music. — Эволюция технологий часто меняла курс творческих индустрий. ИИ, скорее всего, продолжит эту давнюю тенденцию. Однако это нововведение должно гарантировать уважение прав авторов песен и записывающихся исполнителей, включая авторские права». Получателям в указанный в письме срок предлагается подробно описать, какие песни Sony Music использовались для обучения систем ИИ, как был получен доступ к песням, сколько копий было сделано, а также почему копии вообще существовали. Sony Music подчеркнула, что будет обеспечивать соблюдение своих авторских прав «в максимальной степени, разрешённой применимым законодательством во всех юрисдикциях». Нарушение авторских прав становится серьёзной проблемой по мере развития генеративного ИИ, уже сейчас потоковые сервисы, подобные Spotify, наводнены музыкой, созданной искусственным интеллектом. В прошлом месяце в США был опубликован проект закона, который, в случае его принятия, заставит компании раскрывать, какие песни, защищённые авторским правом, они использовали для обучения ИИ. В марте 2024 года Теннесси стал первым штатом США, который принял юридические меры для защиты артистов, после того как губернатор Билл Ли (Bill Lee) подписал «Закон об обеспечении безопасности голоса и изображений» (Ensuring Likeness Voice and Image Security, ELVIS). Reddit откроет OpenAI доступ к контенту для обучения ИИ

17.05.2024 [16:54],

Павел Котов

OpenAI подписала соглашение о доступе к контенту Reddit в реальном времени через API — это значит, что компания сможет отображать обсуждения с сайта в ChatGPT и других новых продуктах. Ранее аналогичное соглашение администрация Reddit заключила с Google — тогда сделку оценили в $60 млн.

Источник изображения: redditinc.com Соглашение также поможет администрации платформы «предоставить пользователям и модераторам Reddit новые функции на основе искусственного интеллекта», а также использовать большие языковые модели OpenAI для создания приложений. OpenAI, кроме того, станет рекламным партнёром Reddit. Пользователи крупнейшего в мире форума никогда не стеснялись высказываться о том, как руководство платформы управляет ей, и неизвестно, как они отреагируют на сделку с OpenAI. В прошлом году более 7000 разделов сайта отключились в знак протеста против введения платного API. Аналогичным образом у платформы для программистов Stack Overflow после заключения сделки с OpenAI без конфликтов с пользователями не обошлось. Reddit не раскрыла финансовых условий сделки, и ни одна из двух компаний не рассказала о наборе данных для обучения ИИ. Сообщая о сделке с Google, руководство платформы открыто говорило о «более эффективных способах обучения моделей». В случае с OpenAI всё обстоит несколько иначе: во-первых, глава компании Сэм Альтман (Sam Altman) является акционером Reddit; во-вторых, известно, что «партнерский проект возглавил главный операционный директор OpenAI с одобрения независимым советом директоров». «Reddit стал одним из крупнейших в интернете архивов аутентичных и актуальных разговоров людей обо всём. Его включение в ChatGPT поддерживает нашу веру в интернет — это поможет людям находить, что они ищут, и поможет новой аудитории найти сообщество на Reddit», — заявил гендиректор платформы Стив Хаффман (Steve Huffman). Прежде администрация форума не всегда приветствовала сбор его данных для обучения ИИ. Она грозилась заблокировать роботам Google доступ к сайту. А OpenAI однажды заявила модераторам форума, посвящённого ChatGPT, что они нарушили авторские права компании, использовав в качестве эмблемы логотип чат-бота. Google показала прямо в рекламном ролике, как ИИ даёт вредный совет

15.05.2024 [17:48],

Павел Котов

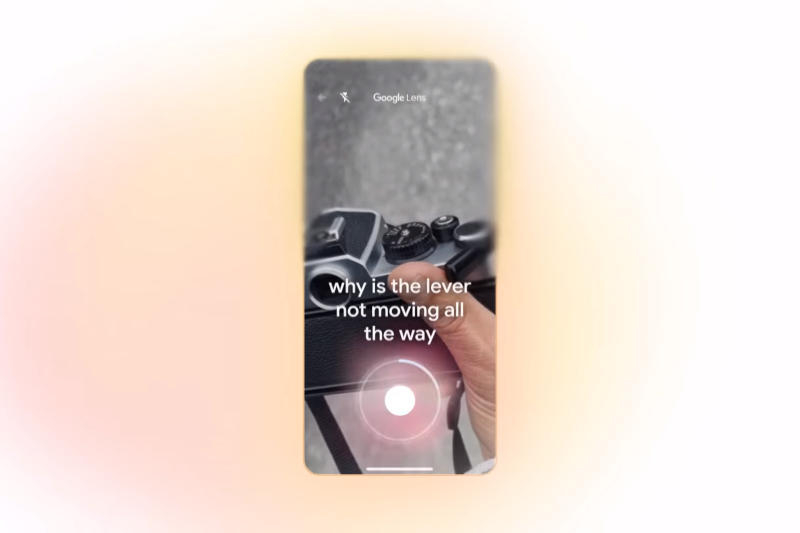

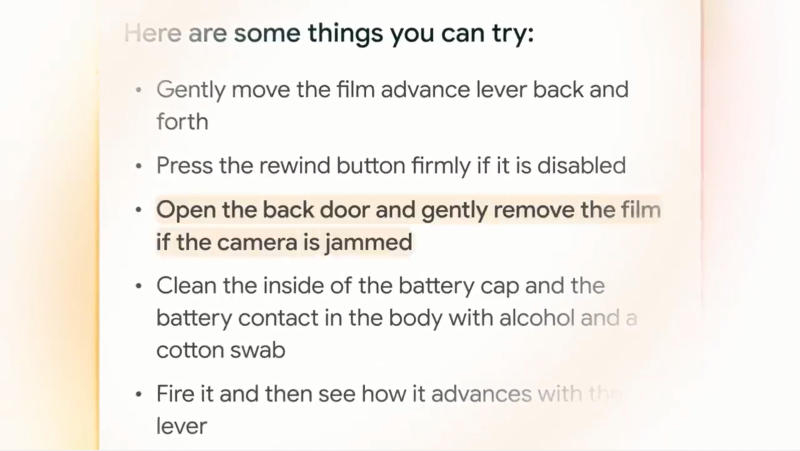

На конференции I/O 2024 компания Google подчеркнула, что разработанный ей нейросети Gemini станут новым словом в поиске и ИИ-ассистентах. Однако одна из самых ярких демонстраций возможностей этой системы снова омрачилась недостатком, присущим всем современным большим языковым моделям — галлюцинациями, то есть дачей заведомо неверного ответа.

Источник изображений: youtube.com/@Google В ролике «Поиск в эпоху Gemini» Google продемонстрировала видеопоиск — функцию поиска информации на основе видео. В качестве одного из примеров компания привела ролик с застрявшим рычажком перемотки плёнки на фотоаппарате и вопросом, почему этот рычажок не движется до конца. Gemini распознал видео, понял запрос и дал несколько советов по исправлению. И как минимум один из них оказался неверным.  ИИ порекомендовал «открыть заднюю крышку и аккуратно снять плёнку». И это, возможно, худшее, что можно сделать в данной ситуации. Потому что если открыть заднюю крышку плёночного фотоаппарата не в абсолютно тёмной комнате, плёнка засветится, и все сделанные снимки придут в негодность. Но на видео этот ответ подсвечен как наиболее подходящий. Google уже не впервые публикует рекламный материал с фактической ошибкой — заведомо неверной информацией, которую даёт ИИ. В прошлом году чат-бот Bard сообщил, что первый снимок экзопланеты — планеты за пределами Солнечной системы — был получен космическими телескопом «Джеймс Уэбб» (JWST), хотя это не так. SEO отправят на пенсию: поисковую выдачу Google сформирует и дополнит генеративный ИИ

15.05.2024 [11:37],

Павел Котов

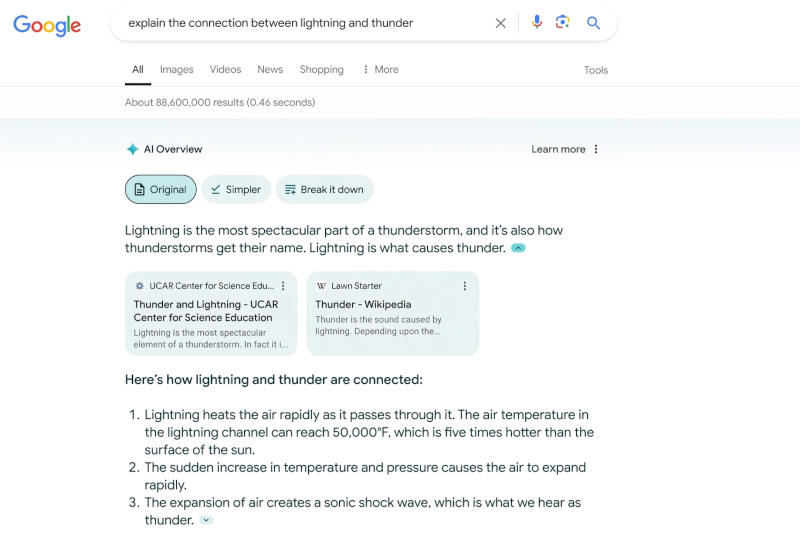

На конференции разработчиков Google I/O 2024 поисковый гигант объявил, что выдачу по некоторым запросам будет формировать генеративный искусственный интеллект. Её дополнит компонент AI Overview — блок со сводкой информации по поисковому запросу, ранее доступный участникам программы тестирования Google AI Labs. До конца года расширится присутствие формата Search Generative Experience (SGE) — его аудитория достигнет миллиарда пользователей.

Источник изображений: blog.google «Не думаем, что всё должно ограничиться сводками ИИ. Есть возможности для внедрения генеративного ИИ в поиск, и одна из областей, которая очень волнует лично меня — это формирование страницы результатов, организованной с помощью ИИ», — пояснила глава подразделения Google Search Элизабет Хармон Рид (Elizabeth Harmon Reid). Пока Google будет показывать страницу результатов поиска нового образца, если станет понятно, что пользователь ищет вдохновения. В приведённом на конференции примере это поездка на юбилей в другой город. Вскоре новый формат также будет подключаться при поиске заведений общепита, рецептов блюд, а за ними последуют кинематограф, книги, отели, покупки и многое другое. В случае с поездкой на юбилей в другой город придётся учесть разные аспекты: патио на крыше подойдёт не во всякое время года, а в качестве досуга можно полюбоваться архитектурой. При поиске ресторана Google покажет карусель с заведениями, продемонстрирует звёздный рейтинг, дополнит выдачу дискуссиями на Reddit и разбавит предложения дополнительной информацией: списками мест с живой музыкой, романтическими стейк-хаусами и материалами ресторанных критиков. А в нижней части страницы на демонстрации появилась кнопка «больше результатов из интернета» — возможно, это ссылка на страницу с традиционной выдачей.  Пока неясно, где на этих страницах будет размещаться реклама. И гендиректор Google Сундар Пичаи (Sundar Pichai) не дал прямого ответа, сохранится ли традиционная выдача при полномасштабном развёртывании инструментов ИИ. «Рад, что мы можем расширить спектр вариантов использования, в которых мы можем помочь пользователям поиска и Gemini. Перед вами примеры тех сложных вопросов, которые мы можем решить, как мы способны помочь в путешествии, интегрировать их с нашими продуктами и помочь более полно. Так что я рассматриваю это лишь с хорошей стороны», — пояснил глава компании. С прошлого года Google тестирует технологию ИИ-поиска SGE (Search Generative Experience). Поначалу её аудитория была крайне ограниченной, со временем она постепенно расширялась; уже на этой неделе SGE смогут пользоваться «сотни миллионов пользователей» из США, а к концу года размер аудитории достигнет миллиарда человек. В компании предупредили, что новый формат не вытеснит традиционного поиска, да и владельцам сайтов беспокоиться не стоит: при тестировании SGE пользователи переходили на внешние ресурсы ещё чаще, чем со страницы традиционной поисковой выдачи. Google не планирует тотального насаждения ИИ, считая его полезным в работе со сложными запросами и разрозненной информацией. Участвующий в поиске ИИ Gemini также окажется полезным в планировании. К примеру, если пользователь захочет составить программу питания семьи из четырёх человек на три дня, ИИ предложит ссылки на рецепты блюд. Gemini готов помочь в планировании и более масштабных мероприятий — поездок или вечеринок. Google показала Project Astra — ИИ-ассистента будущего, который видит и понимает всё вокруг

15.05.2024 [08:18],

Владимир Фетисов

Глава ИИ-подразделения Google DeepMind Демис Хассабис (Demis Hassabis) в рамках ежегодной конференции для разработчиков Google I/O рассказал о ранней версии того, что в компании называют универсальным ИИ-помощником. Речь идёт о системе под кодовым названием Project Astra, которая представляет собой мультимодальный ИИ-помощник, работающий в режиме онлайн. Он может «видеть» окружающее пространство, распознавать объекты и помогать в выполнении различных задач.

Источник изображения: Google «Я уже давно вынашивал эту идею. У нас будет этот универсальный помощник. Он мультимодальный, он всегда с вами<…> Этот помощник просто полезен. Вы привыкните к тому, что он всегда рядом, когда это нужно», — рассказал Хассабис во время презентации. Вместе с этим Google опубликовала небольшое видео, в котором демонстрируются некоторые возможности ранней версии Project Astra. Одна из сотрудниц лондонского офиса Google активирует ИИ-помощника и просит его сообщить, когда он «увидит» что-либо, способное издавать звуки. После этого она начинает поворачивать смартфон и когда в объектив камеры попадает стоящая на столе колонка, алгоритм сообщает об этом. Далее она просит описать стоящие на столе в стакане цветные мелки, на что алгоритм отвечает, что с их помощью можно создавать «красочные творения». Далее камера телефона направляется на часть монитора, на котором в это время выведен программный код. Девушка спрашивает ИИ-алгоритм, за что именно отвечает эта часть кода и Project Astra практически моментально даёт верный ответ. Далее ИИ-помощник определил местонахождение офиса Google по «увиденному» из окна пейзажу и выполнил ряд других задач. Всё это происходило практически в режиме онлайн и выглядело очень впечатляюще. По словам Хассабиса, Project Astra намного ближе предыдущих аналогичных продуктов к тому, как должен работать настоящий ИИ-помощник в режиме реального времени. Алгоритм построен на базе большой языковой модели Gemini 1.5 Pro, наиболее мощной нейросети Google на данный момент. Однако для повышения качества работы ИИ-помощника Google пришлось провести оптимизацию, чтобы повысить скорость обработки запросов и снизить время задержки при формировании ответов. По словам Хассабиса, последние шесть месяцев разработчики трудились именно над тем, чтобы ускорить работу алгоритма, в том числе за счёт оптимизации всей связанной с ним инфраструктуры. Ожидается, что в будущем Project Astra появится не только в смартфонах, но и в смарт-очках, оснащённых камерой. Поскольку на данном этапе речь идёт о ранней версии ИИ-помощника, точные сроки его запуска в массы озвучены не были. Google представила Gemini Live — ИИ-ассистента с памятью, естественной речью и компьютерным зрением

14.05.2024 [22:12],

Андрей Созинов

Во вторник на конференции Google I/O 2024 была анонсирована новая возможность для ИИ-чат-бота Gemini — функция Gemini Live, которая позволяет пользователям вести «углубленные» голосовые диалоги с Gemini на своих смартфонах. Пользователи могут прерывать Gemini во время его реплик, чтобы задать уточняющие вопросы, и чат-бот будет адаптироваться к речи пользователя в режиме реального времени. Кроме того, Gemini может видеть и реагировать на окружение пользователя, используя фотографии или видео, снятые камерами смартфонов.

Источник изображений: Google Gemini Live — это в некотором роде соединение платформы компьютерного зрения Google Lens и виртуального помощника Google Assistant, и их дальнейшая эволюция. На первый взгляд Gemini Live не кажется кардинальным обновлением по сравнению с существующими технологиями. Но Google утверждает, что система использует новые методы генеративного ИИ, чтобы обеспечить превосходный, менее подверженный ошибкам анализ изображений, и сочетает эти методы с улучшенным речевым движком для более последовательного, эмоционально выразительного и реалистичного многооборотного диалога. Технические инновации, используемые в Gemini Live, частично связаны с проектом Project Astra, новой инициативой DeepMind по созданию приложений и «агентов» на базе ИИ с поддержкой «понимания» в реальном времени различных источников данных — текста, аудио и изображения. «Мы всегда хотели создать универсального агента, который будет полезен в повседневной жизни, — сказал на брифинге Демис Хассабис (Demis Hassabis), генеральный директор DeepMind. — Представьте себе агентов, которые могут видеть и слышать то, что мы делаем, лучше понимать контекст, в котором мы находимся, и быстро реагировать в разговоре, делая темп и качество взаимодействия гораздо более естественными». Gemini Live, который будет запущен только в конце этого года, сможет отвечать на вопросы о предметах, находящихся в поле зрения (или недавно попавших в поле зрения) камеры смартфона, например, в каком районе находится пользователь или как называется сломавшаяся деталь велосипеда. Либо пользователь сможет указать системе на часть компьютерного кода, а Live объяснит, за что она отвечает. А на вопрос о том, где могут находиться очки пользователя, Gemini Live скажет, где он видел их в последний раз. А как это облегчит поиск потерянного пульта от телевизора! Live также сможет стать своеобразным виртуальным наставником, помогая пользователям отрепетировать речь к мероприятию, обдумать идеи и так далее. Live может подсказать, какие навыки следует подчеркнуть на предстоящем собеседовании или стажировке, или дать совет по публичному выступлению. Способность Gemini Live «запоминать», что происходило недавно, стала возможной благодаря архитектуре модели, лежащей в ее основе — Gemini 1.5 Pro, а также, но в меньшей степени, других «специфических» генеративных моделей. У Gemini 1.5 Pro весьма ёмкое контекстное окно, а значит, она может принять и обработать большое количество данных — около часа видео — прежде чем подготовить ответ. В Google отметили, что Gemini Live будет помнить всё, что происходило в последние часы. Gemini Live напоминает генеративный ИИ, применяемый в очках Meta✴, которые аналогичным образом могут просматривать изображения, снятые камерой, и интерпретировать их практически в реальном времени. Судя по демонстрационным роликам, которые Google показала во время презентации, Live также очень похож на недавно обновленный ChatGPT от OpenAI. Ключевое различие между новым ChatGPT и Gemini Live заключается в том, что решение от Google не будет бесплатным. После запуска Live будет эксклюзивом для Gemini Advanced, более сложной версии Gemini, которая доступна подписчикам плана Google One AI Premium Plan, стоимостью 20 долларов в месяц. Возможно, в качестве отсылки к очкам Meta✴, в одном из демонстрационных роликов Google был показан человек в AR-очках, оснащенных приложением, похожим на Gemini Live. Правда, компания Google, желая избежать очередного провала в сфере умных очков, отказалась сообщить, появятся ли этот или подобный продукт с генеративным ИИ на рынке в ближайшем будущем. ИИ-чат-бот Anthropic Claude запущен в Европе — это один из главных конкурентов ChatGPT

14.05.2024 [12:41],

Павел Котов

Специализирующийся на технологиях искусственного интеллекта стартап Anthropic открыл для европейских пользователей чат-бот Claude и услуги по подписке — в стремлении нарастить число пользователей и объёмы доходов компания решилась выйти на рынок с более жёстким регулированием, чем в США.

Источник изображения: anthropic.com Базовые программные продукты от Anthropic уже пользуются некоторой популярностью в финансовом секторе и гостиничном бизнесе, сообщили в компании, и теперь здесь решили закрепить успех. Соблюдать действующие в Европе жёсткие ограничения на управление данными Anthropic помогут её основные партнёры в области облачных вычислений — Amazon и Google, — сообщил гендиректор компании Дарио Амодей (Dario Amodei). Anthropic, основанная в 2021 году бывшими сотрудниками OpenAI, позиционирует себя как разработчика ответственного и этичного ИИ. Подобно многим другим представителям отрасли, компания уделяет много внимания продаже услуг корпоративным клиентам. В мае Anthropic представила корпоративный тарифный план Team, но спрос на него глава компании комментировать отказался. В Европе цены будут аналогичными — здесь стартапу придётся конкурировать с OpenAI и французским разработчиком Mistral. Anthropic также придётся соблюдать требования принятого ранее «Закона об ИИ». Он требует от разработчиков применять адекватные средства контроля кибербезопасности, а также раскрывать некоторые подробности об архитектуре и потенциальных угрозах, которые могут представлять модели ИИ. Механизмы соблюдения требований закона будут зависеть правоприменительной практики, которую станут реализовывать местные регуляторы, отметил соучредитель компании Джек Кларк (Jack Clark). В Великобритании запустили платформу для оценки безопасности ИИ

12.05.2024 [15:37],

Владимир Мироненко

Британский Институт безопасности ИИ (AISI), созданный в ноябре 2023 года, запустил платформу Inspect, предназначенную для тестирования и оценки безопасности ИИ. Она упростит оценку ИИ для применения в промышленных, исследовательских и научных организациях.

Источник изображения: geralt/Pixabay Набор инструментов Inspect, доступный по лицензии с открытым исходным кодом, включая лицензии MIT, предназначен для оценки определённых возможностей моделей ИИ в различных сферах, включая основные знания моделей и способность рассуждать, и выработки оценки на основе полученных результатов. По данным ресурса TechCrunch, платформа Inspect состоит из трех основных компонентов: наборов данных, инструментов решения и инструментов оценки. Наборы данных предоставляют образцы для оценочных тестов. Инструменты решения выполняют работу по проведению тестов. А инструменты оценки оценивают результаты и суммируют баллы тестов в метрики. Компоненты Inspect можно дополнить с помощью сторонних пакетов, написанных на Python. «Мы надеемся, что глобальное сообщество ИИ будет использовать Inspect не только для проведения собственных испытаний на безопасность моделей, но и для адаптации и развития платформы с открытым исходным кодом, чтобы мы могли производить высококачественные оценки по всем направлениям», — заявил председатель AISI Ян Хогарт (Ian Hogarth). Платформа Inspect была представлена спустя несколько дней после того, как Национальный институт стандартов и технологий США (The National Institute of Standards and Technology, NIST) анонсировал в конце апреля программу NIST GenAI, предназначенную для оценки различных технологий генеративного ИИ, включая модели, генерирующие текст и изображения. В апреле США и Великобритания объявили о партнёрстве, в рамках которого «правительства будут обмениваться техническими знаниями, информацией и талантливыми специалистами в области безопасности ИИ». В рамках сотрудничества в США будет создан институт безопасности ИИ, который займётся оценкой рисков, связанных с ИИ и генеративным ИИ. 64 пикселя за 20 минут: на 40-летнем компьютере Commodore 64 запустили ИИ-генератор изображений

10.05.2024 [17:58],

Павел Котов

В августе 1982 года вышел компьютер Commodore 64, которому было суждено стать одним из самых продаваемых ПК всех времён. Как оказалось, оборудование той эпохи и может справляться и с современными алгоритмами искусственного интеллекта — конечно, с некоторыми оговорками.

Источник изображения: github.com/nickbild Энтузиаст Ник Бильд (Nick Bild) разработал для Commodore 64 систему генеративного ИИ, способную создавать изображения размером 8 × 8 пикселей, которые затем преобразуются в картинки 64 × 64 точки. Эти изображения призваны служить источником вдохновения при разработке концепций игрового дизайна. Как оказалось, современную модель генеративного ИИ действительно можно запускать на таком старом оборудовании. На выполнение 94 итерации для построения окончательного изображения у Commodore 64 ушли 20 минут — и это, пожалуй, совсем неплохо, учитывая возраст компьютера. О проектах уровня OpenAI речи, конечно, не идёт, но и «вероятностный алгоритм PCA», запущенный на 40-летней машине, в реальности был обучен на современном компьютере. Таким образом, хотя модель и по-честному работала на Commodore 64, для её запуска всё равно оказался необходим современный ПК. В США разработан законопроект, который позволит ограничивать экспорт моделей ИИ

10.05.2024 [16:55],

Павел Котов

Американские парламентарии разработали законопроект, который облегчит администрации президента установление экспортного контроля над моделями искусственного интеллекта — это очередная попытка США защитить свои технологии от посягательств считающихся недружественными стран.

Источник изображения: Brian Penny / pixabay.com Документ подготовлен представителями обеих крупнейших политических партий США — она также предоставит Министерству торговли полномочия запрещать американским специалистам сотрудничество с иностранцами при разработке систем ИИ, если те представляют угрозу для национальной безопасности страны. Законопроект призван защитить любые будущие нормы экспортного контроля в отношении ИИ от юридических проблем — в его разработке участвовали чиновники администрации президента. В политической среде США растут опасения, что считающиеся недружественными страны будут использовать американские модели ИИ для проведения кибератак или создания мощного биологического оружия. В минувшую среду стало известно, что США готовятся открыть новый фронт санкционной войны с Россией и Китаем и начали изучать план по введению экспортного контроля в отношении передовых моделей ИИ. В соответствии с действующим законодательством курирующему экспортную политику Минторгу США значительно сложнее контролировать экспорт открытых моделей ИИ, которые можно свободно загрузить. Принятие закона устранит препятствия на пути регулирования экспорта открытых моделей ИИ — такие препятствия накладывает действующий «Закон о чрезвычайных международных экономических полномочиях», — а Минторг получит особые полномочия по регулированию систем ИИ. В марте китайские государственные СМИ распространили заявление Пекинской академии искусственного интеллекта, согласно которому большинство моделей ИИ в стране были созданы с использованием открытых моделей Meta✴ Llama, и это большая проблема для китайских разработчиков. В ноябре считавшийся перспективным китайский стартап 01.AI, учреждённый бывшим топ-менеджером Google Ли Кай-фу (Lee Kai-fu) подвергся резкой критике, когда инженеры в области ИИ обнаружили, что разработанная стартапом модель также была построена на основе Llama. Новая статья: Практикум по ИИ-рисованию, часть восьмая: больше жизни!

10.05.2024 [00:03],

3DNews Team

Данные берутся из публикации Практикум по ИИ-рисованию, часть восьмая: больше жизни! McAfee продемонстрировала детектор звуковых дипфейков

09.05.2024 [15:08],

Павел Котов

На мероприятии RSA Conference компания McAfee продемонстрировала систему Deepfake Detector, работа над которой ведётся при участии Intel. Система, первоначально называвшаяся Project Mockingbird, предназначена для обнаружения звуковых дипфейков — аудиоподделок, созданных при помощи искусственного интеллекта.

Источник изображения: S. Keller / pixabay.com Технический директор McAfee Стив Гробман (Steve Grobman) показал работу Deepfake Detector на примере двух видеороликов — показ видео сопровождается информацией от ИИ-детектора, которая выводится в строке состояния. При запуске видеоролика, не подвергавшегося обработке, система показала нулевую вероятность подделки. Далее было запущено явно фейковое видео, на которое система сразу отреагировала показателем в 60 %, и по мере просмотра вероятность выросла до 95 %. С момента первой демонстрации на CES 2024 инженеры McAfee оптимизировали систему для работы с ИИ-ускорителями Intel NPU на чипах Meteor Lake, что позволило увеличить производительность на 300 %. Можно запускать несколько процессов Deepfake Detector для одновременного анализа нескольких видеороликов; хотя и видеозаписями возможности системы не ограничиваются — она может анализировать звук любого приложения в системе. А локальный режим её работы вместо запуска из облака означает высокую конфиденциальность — анализируемые данные не покидают компьютера. Авторы проекта преднамеренно ограничились работой со звуком: специалисты McAfee по борьбе с угрозами обнаружили, что во многих публикуемых мошенниками видеороликах используется настоящее видео с поддельным звуком. Фальшивый звук сопровождает и поддельное видео, а значит, постоянной величиной чаще всего оказывается подделка аудио. Сейчас компания работает над адаптацией технологии для потребителей — для этого управление программой будет необходимо сделать предельно простым и понятным. Google представила мощную нейросеть AlphaFold 3 для предсказания структуры белков — её может опробовать каждый

09.05.2024 [12:38],

Павел Котов

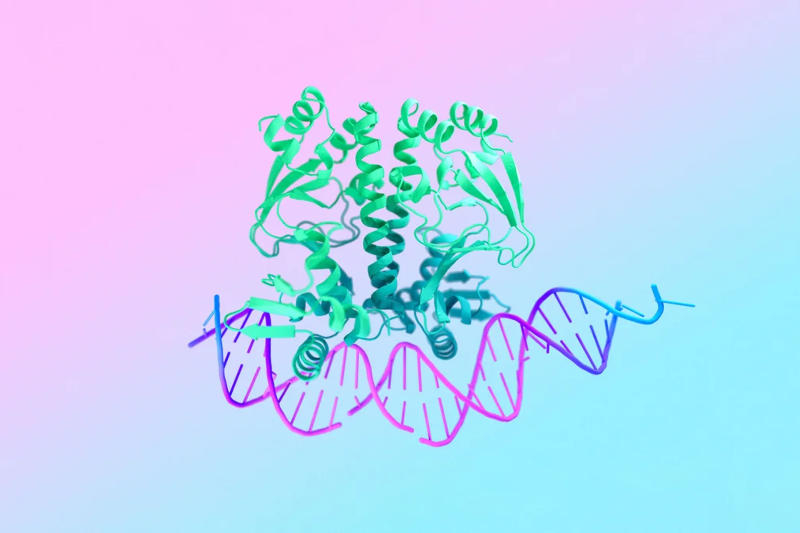

Подразделение Google DeepMind представило новую версию модели искусственного интеллекта AlphaFold, которая предсказывает форму и поведение белков. AlphaFold 3 отличается не только более высокой точностью — теперь система предсказывает взаимодействие белков с другими биологическими молекулами; кроме того, её ограниченная версия теперь бесплатно доступна в формате веб-приложения.

Источник изображения: blog.google С выхода первой нейросети AlphaFold в 2018 году она стала ведущим методом прогнозирования структуры белков на основе последовательностей аминокислот, из которых они состоят. Понимание структуры и основ взаимодействия белков лежит в основе почти всей биологии. Классические методы моделирования белков имеют значительные ограничения: даже зная форму, которую примет последовательность аминокислот, нельзя сказать наперёд, с какими другими молекулами она будет связываться и как. И если необходимо достичь какой-то практической цели, требуется кропотливая работа по моделированию и тестированию — ранее на это уходили несколько дней, а иногда даже недель и месяцев. AlphaFold решает эту задачу, предсказывая вероятную форму молекулы белка по заданной последовательности аминокислот, указывая, с какими другими белками она сможет взаимодействовать. Особенность новой AlphaFold 3 состоит в её способности предсказывать взаимодействие белков с другими биологическими молекулами, в том числе с цепочками ДНК и РНК, а также необходимыми для этого ионами. Большой проблемой AlphaFold, как и других инструментов на основе ИИ, является сложность в их развёртывании. Поэтому в Google DeepMind запустили бесплатное веб-приложение AlphaFold Server — оно доступно для некоммерческого использования. Платформа достаточно проста в работе: осуществив вход с учётной записью Google, можно ввести несколько последовательностей и категорий, после чего она выдаст результат в виде трёхмерной молекулы, окрашенной в цвет, который отражает уверенность модели в своей правоте. На вопрос о том, есть ли существенная разница между общедоступной версией модели и той, что используется внутри компании, глава подразделения Google DeepMind Демис Хассабис (Demis Hassabis) заверил, что «мы сделали доступными большинство функций новой модели», но подробностей не привёл. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |